L'intelligence artificielle (IA) représente une avancée technologique majeure aux implications profondes dans tous les aspects de la société moderne. De plus, ce phénomène s'est accéléré avec l'arrivée des IA génératives telles que ChatGPT, Midjourney, Dall-E, Gemini (Bard), LLAMA.

De la santé à la finance en passant par l'industrie et les services publics, l'IA promet des avantages considérables.

Cependant, son déploiement soulève également des préoccupations éthiques, sociales et juridiques, conduisant ainsi les gouvernements à mettre en place des réglementations pour encadrer son utilisation.

L'Union européenne a approuvé une nouvelle législation sur l'intelligence artificielle (IA) en avril 2024 : Le règlement sur l'IA, la première loi globale sur l'IA au monde.

Définition de l'intelligence artificielle

L'intelligence artificielle (IA) sert à automatiser des tâches, analyser des données, prendre des décisions, personnaliser les expériences utilisateur et créer des systèmes autonomes dans divers domaines tels que la santé, la finance, la fabrication et bien d'autres encore.

Le développement d'une intelligence artificielle implique la conception, l'entraînement et l'optimisation d'algorithmes et de modèles informatiques pour permettre à un système de simuler des processus cognitifs humains ou d'accomplir des tâches spécifiques de manière autonome. Le système d'intelligence artificielle est développé en utilisant diverses techniques d'apprentissage, les principales sont les suivantes :

- Apprentissage supervisé : dans cette méthode, le modèle d'IA est entraîné sur un ensemble de données étiquetées, où chaque exemple de données est associé à une étiquette ou une sortie désirée.

- Apprentissage non supervisé : le modèle d'IA est exposé à des données non étiquetées et cherche à découvrir des structures ou des modèles intrinsèques à ces données.

- Apprentissage par renforcement : un agent qui interagit avec un environnement dynamique et reçoit des récompenses ou des pénalités en fonction des actions qu'il prend.

C'est quoi l'AI Act ?

L'AI Act, ou RIA, est une réglementation conçue pour encadrer et promouvoir le développement ainsi que la mise sur le marché des systèmes d'intelligence artificielle au sein de l'Union européenne.

Lancé par la Commission européenne en avril 2021, l'IA Act est rentré en vigueur le 12 juillet 2024, après trois années de négociations.

L'AI Act définit le concept de système d'IA qui correspond à un usage de l'IA au sein de l'organisation.

Quel est l'objectif de l'IA Act ?

Le règlement sur l'IA a pour objectif d'établir des directives claires et précises à l'attention des développeurs et des utilisateurs d'IA. Cette règlementation vise également à réduire les contraintes administratives et financières imposées aux entreprises, notamment les petites et moyennes entreprises (PME).

Cette initiative a pour but de favoriser le développement d'une IA de confiance, garantissant les droits fondamentaux, la sécurité et les principes éthiques, tout en encourageant et en renforcent l’investissement et l’innovation de l’IA dans l’ensemble de l’UE.

Pourquoi la régulation de l'intelligence artificielle est-elle nécessaire ?

Le règlement sur l'IA vise à instaurer la confiance des citoyens européens dans les technologies de l'Intelligence artificielle. Bien que la plupart des systèmes d'IA présentent peu de risques et contribuent à résoudre divers défis sociétaux, certains d'entre eux posent des risques qu'il est important d'éviter.

Bien que les lois existantes comme le RGPD offrent une certaine protection, elles ne sont pas suffisantes pour souligner les risques que l'IA peut présenter. C'est pourquoi des règles ont été proposées pour :

- Cibler les risques spécifiques associés à l'IA

- Interdire les pratiques d'IA présentant des risques inacceptables

- Définir des critères clairs pour les systèmes d'IA utilisés dans ces applications

- Imposer des obligations spécifiques aux utilisateurs et fournisseurs de ces applications

- Exiger une évaluation de la conformité avant la mise en service ou la commercialisation d'un système d'IA

- Surveiller l'application des règles après la commercialisation d'un système d'IA

- Mettre en place une structure de gouvernance aux niveaux européen et national.

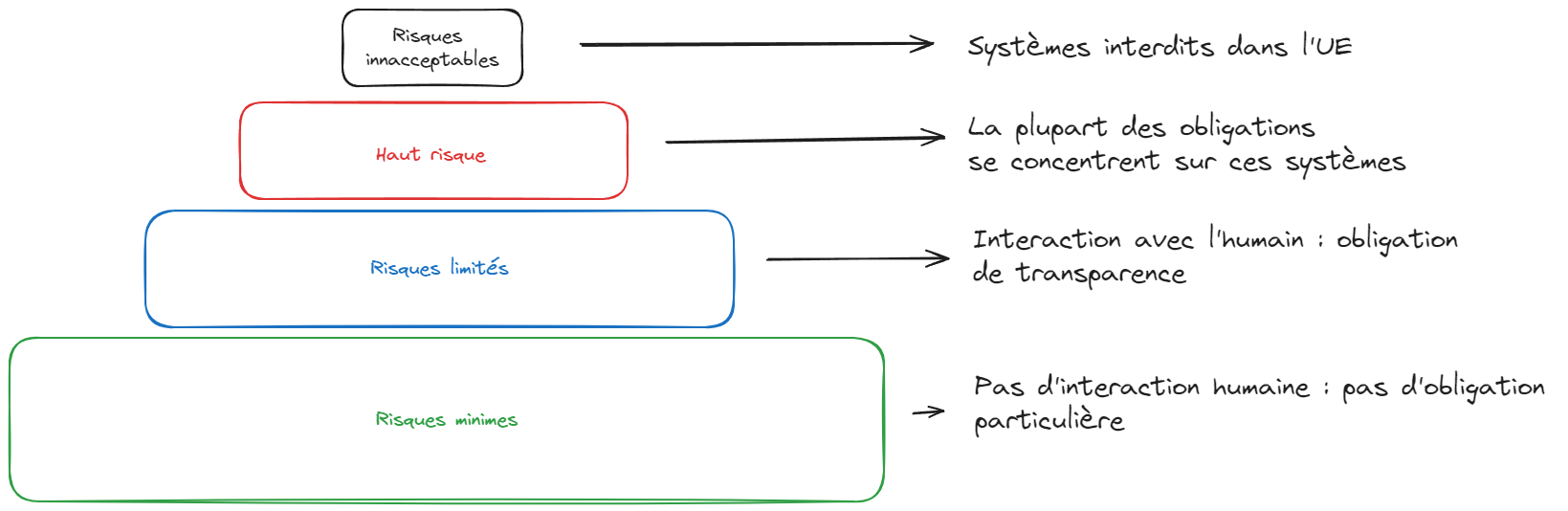

Les formes de risques

L'approche des systèmes d'IA est fondée sur les risques. Le cadre réglementaire établit 4 catégories de risque pour les systèmes d'intelligence artificielle (SIA). Selon les étages de la pyramide, la régulation ne va pas être la même.

Les risques inacceptables :

Les systèmes et modèles d'intelligence artificielle présentant un risque inacceptable sont proscrits et ne peuvent être mis sur le marché ni utilisés à l'exportation dans l'Union européenne. Il s'agit des systèmes d'IA considérés comme une menace claire pour la sécurité, les moyens de subsistance et les droits des personnes, de la notation sociale par les gouvernements aux jouets utilisant une assistance vocale qui encourage les comportements dangereux.

Exemples : scoring social, lidentification biométrique généralisée, deepfakes, manipulation de contenu, porter atteinte à certaines catégories de la population, etc.)

Les risques élevés :

Les systèmes d'intelligence artificielle jugés à haut risque englobent les domaines suivants :

- Les infrastructures critiques telles que les transports, pouvant mettre en péril la vie et la santé des citoyens.

- L'éducation et la formation professionnelle, qui peuvent influencer l'accès à l'éducation et aux opportunités professionnelles tout au long de la vie d'une personne, par exemple à travers l'évaluation des examens.

- Les composants de sécurité des produits, comme l'utilisation de l'IA dans la chirurgie assistée par robot.

- L'emploi, la gestion des employés et l'accès au travail indépendant, par exemple avec l'utilisation de logiciels de tri de CV pour les processus de recrutement.

- Les services publics et privés essentiels, par exemple l'utilisation de l'IA pour évaluer le crédit et refuser aux citoyens la possibilité d'obtenir un prêt.

- Les services répressifs qui pourraient porter atteinte aux droits fondamentaux des individus, comme l'évaluation de la fiabilité des preuves.

- La gestion de la migration, de l'asile et du contrôle aux frontières, par exemple à travers l'examen automatisé des demandes de visa.

- L'administration de la justice et les processus démocratiques, tels que les solutions d'IA utilisées pour rechercher des décisions de justice.

Les systèmes d'IA à haut risque doivent respecter des obligations strictes avant d'être autorisés sur le marché, comprenant :

- L'implémentation de méthodes d'évaluation et de réduction des risques adéquates.

- L'utilisation de ensembles de données de haute qualité pour minimiser les risques et éviter les résultats discriminatoires.

- La tenue d'un registre de logs pour garantir la traçabilité des résultats.

- La création d'une documentation détaillée fournissant toutes les informations nécessaires sur le système et son objectif, afin de permettre aux autorités d'évaluer sa conformité.

- La fourniture d'informations claires et appropriées pour les utilisateurs.

- La mise en place de mesures de surveillance humaine pour minimiser les risques.

- Le maintien d'un niveau élevé de robustesse, de sécurité et de précision.

Tous les systèmes d'identification biométrique à distance sont considérés comme présentant un haut risque et sont donc soumis à des exigences strictes. L'utilisation de tels systèmes dans des espaces publics à des fins répressives est fondamentalement interdite.

Des exceptions sont autorisées dans des circonstances spécifiques et réglementées de manière stricte, telles que :

- la recherche d'un enfant disparu

- la prévention d'une menace terroriste imminente

- la recherche, localisation, identification ou poursuite d'auteurs ou de suspects d'infractions pénales graves

Ces utilisations nécessitent une autorisation préalable d'un organisme judiciaire ou d'un autre organisme indépendant, ainsi que des limitations appropriées en termes de durée, de zone géographique et de bases de données consultées.

Les risques limités/modérés :

Un risque limité ou modéré fait référence aux dangers liés au manque de transparence dans l'utilisation de l'intelligence artificielle.

La législation sur l'IA introduit des obligations spécifiques en matière de transparence pour assurer que les individus sont informés lorsque cela est nécessaire, renforçant ainsi la confiance.

Exemple : lors de l'interaction avec des systèmes d'IA tels que les chatbots, les individus doivent être informés qu'ils communiquent avec une machine, afin qu'ils puissent prendre une décision éclairée sur la poursuite ou la rétractation de leur interaction.

Les fournisseurs devront donc garantir que le contenu produit par l'IA est identifiable. De plus, les textes générés par l'IA et publiés dans le but d'informer le public sur des questions d'intérêt général devront être clairement indiqués comme étant générés par l'intelligence artificielle.

Cette exigence s'applique également aux contenus audio et vidéo qui pourraient constituer des deepfakes.

Les risques Minimes ou nul:

La législation sur l'intelligence artificielle, IA Act, autorise l'utilisation libre de l'IA présentant un risque minimal ! La plupart des systèmes d'IA actuellement en usage dans l'UE entrent dans cette catégorie.

Exemple : Bot de jeux vidéos, filtres antispams etc.

À quelle échéance doit-on assurer la conformité ?

Des délais variant de 6 à 36 mois sont prévus en fonction du niveau de risque des systèmes d'intelligence artificielle. Quel que soit ce délai, il est crucial de se préparer et d'anticiper les ajustements nécessaires, susceptibles de perturber les feuilles de route technologiques, produits et juridiques des entreprises.

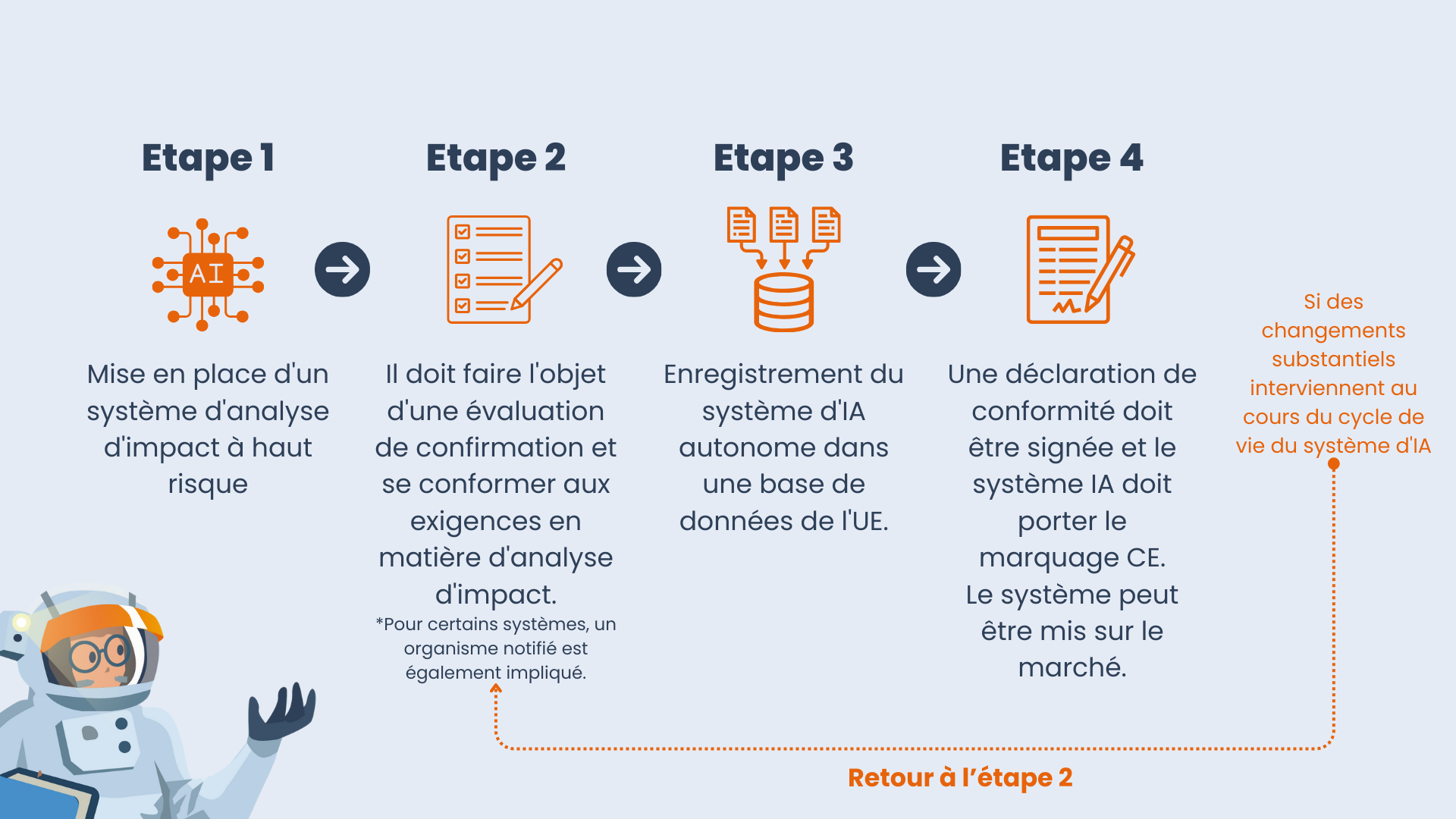

Comment opèrent concrètement les fournisseurs de systèmes d'IA à haut risque ?

Quels sont les sanctions en cas de non-respect de l'IA Act ?

Des pénalités significatives, similaires à celles prévues par le RGPD en cas de non-respect du Règlement, sont envisagées pour les infractions à l'AI Act. Cette législation va même plus loin en intensifiant les sanctions pour les utilisations jugées "inacceptables" de l'intelligence artificielle. Ainsi, en cas de non-conformité à ces règles, une amende pouvant atteindre 30 millions d'euros ou 6% du chiffre d'affaires pour les entreprises est prévue. Pour les autres violations de l'AI Act, l'amende peut s'élever à 20 millions d'euros ou 5% du chiffre d'affaires pour les entreprises.

De plus, l'AI Act prévoit des amendes pour le défaut de coopération avec les autorités nationales de l'Union européenne, pouvant aller jusqu'à 10 millions d'euros ou 2% du chiffre d'affaires.

Répondre aux exigences de l'IA Act avec Dastra

Notre Logiciel Dastra, vous aidera très facilement à répondre à mettre en place la réglementation de l'IA Act. Dastra inclut désormais un registre des systèmes d'IA complet avec analyse des risques intégrées, cartographie des actifs, données et modèles d'IA concernés. Vos problèmes de gouvernance de l'IA seront ainsi complètement résolus !